En ciencia raramente nos encontramos frente a un experimento bien diseñado, con doble ciego, repetido varias veces, aleatorio, con controles, con un tamaño muestral suficiente y con conclusiones inequívocas respecto al tema que se investiga.

Hay muchos factores que influyen en los experimentos y sobre todo en la interpretación de los resultados.

Hace un par de años, un profesor de biología de la conservación, un matemático (ambos de Cambridge), y un investigador de botánica australiano publicaron en Nature veinte consejos para ayudar a interpretar la ciencia. Son ideas que nos pueden ayudar a todos a mantener un cierto criterio a la hora de enfrentarnos a los datos científicos que nos presentan estudios no solo biológicos, sino también sociológicos o estadísticos. Especialmente interesante puede ser para aquellas personas que, sin conocimientos científicos, tiene capacidad de decisión y gestión política.

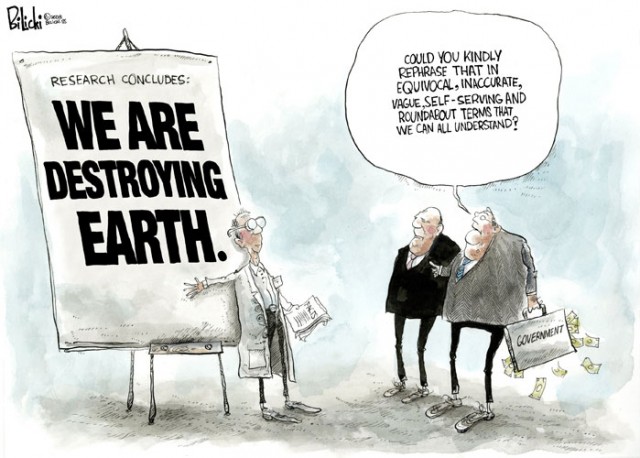

Política y ciencia se enfrentan en temas como el cambio climático, la desaparición de las abejas, la energía nuclear, los transgénicos o el control de las enfermedades infecciosas.

Te animo a consultar directamente el artículo original, porque yo aquí resumo y hago una interpretación personal de lo que me ha parecido más interesante.

1. El mundo real varía de forma impredecible.

La ciencia se dedica en parte a descubrir las causas de los patrones que vemos, pero puede haber muchas explicaciones para un mismo fenómeno. Uno de los principales retos de la investigación científica es encontrar la razón de la realidad, sin olvidar las innumerables fuentes de variación.

2. Ninguna medida es exacta.

Prácticamente todas las medidas tiene algún error. Si mides un proceso varias veces, lo normal es que obtengas resultados diferentes. Los resultados deben presentarse siempre con el error asociado a la medición.

3. El sesgo es frecuente.

El diseño experimental o el método de medida puede producir resultados atípicos o sesgados en una determinada dirección. Por ejemplo, en un ensayo clínico el resultado puede estar influenciado por la expectativas que tengan los participantes en dicho ensayo. Pero además, el mismo investigador que recoge y analiza los resultados también puede estar influenciado si conoce el tratamiento de antemano. Por eso, lo ideal en este tipo de ensayos son los experimentos doble ciego, en los que ni los participantes ni el investigador conocen quién ha recibido qué tratamiento concreto. El sesgo ocurre cuando un investigador deja de ser lo suficientemente crítico, objetivo e imparcial con sus propios resultados o cesa de investigar si hay evidencias contrarias a su hipótesis de partida.

4. Cuanto mayor sea el tamaño de la muestra mejor.

Los resultados obtenidos con un mayor número de observaciones suelen ser más informativos y fiables que los que se obtienen de un menor número de datos. Es decir, conforme acumulamos más evidencias nuestro conocimiento mejora. Esto es especialmente importante en las encuestas, por ejemplo, o cuando nuestro estudio está sujeto a variaciones naturales o a errores de medida. La efectividad de un tratamiento puede variar de forma natural entre personas distintas, por eso, un ensayo clínico es más fiable si se ensaya en decenas de miles de individuos en vez de en unos pocos cientos.

5. Correlación no implica causalidad.

Suele ser muy tentador asumir que un determinado hecho es la causa de otro. Sin embargo, quizá esa correlación entre hechos puede ser mera coincidencia. Un ejemplo actual puede ser la correlación en el tiempo entre la edad a las que se ponen algunas vacunas y la aparición del autismo, que no implica que la causa del autismo sean las vacunas.

6. La regresión a la media puede ser engañosa.

No se puede descartar que los valores extremos obtenidos en un experimento sean debidos, en parte, a anormalidades debidas al azar o a errores de medida.

7. Extrapolar mas allá de los datos suele ser arriesgado.

Los patrones de comportamiento encontrados en un determinado experimento no necesariamente pueden aplicarse fuera de ese experimento concreto. Por ejemplo, es muy difícil predecir la respuesta de un sistema ecológico a los cambios del clima, cuando los cambios son muy rápidos o nuevos, o cuando cambian las condiciones.

8. Cuidado con la falacia de la tasa de referencia.

La capacidad de un test imperfecto de identificar una condición depende de la probabilidad de que esa condición ocurra. Por ejemplo, una persona puede dar positivo en un test que detecta una enfermedad muy rara y con muy baja prevalencia, con una exactitud del 99%, pero sin embargo no padecer esa enfermedad. Si ese test se aplica a 10.001 personas de las que solo 1 tiene la enfermedad, probablemente el test la detecte, pero puede haber otras 100 que den positivo (el 1 %) y que no estén enfermas, son falsos positivos.

9. Los controles son (muy) importantes.

Todos los experimentos deben tener su grupo control. El grupo control hay que tratarlo igual que al grupo experimental, excepto que no se le aplica el tratamiento, por ejemplo. Sin un control en el experimento es muy difícil determinar si un tratamiento realmente ha sido efectivo. El control ayuda a los investigadores a interpretar los resultados y a estar seguros de que los resultados obtenidos no son debidos a otras variables que pueden afectar a los resultados. En los ensayos clínicos algunas persona pueden dar resultado positivo debido al contexto, a la persona que interviene o incluso ¡al color de la pastilla! Es lo que se denomina efecto placebo, un fenómeno que ocurre cuando los síntomas de un paciente mejoran por el tratamiento con una sustancia inocua, es decir, una sustancia que no tiene ningún efecto relacionados con el tratamiento de la enfermedad. Es decir, es el propio paciente el que se influencia a sí mismo por la sensación de ser tratado o la esperanza de curarse, y como resultado puede encontrarse mejor o incluso facilitar la recuperación.

10. La distribución aleatoria reduce el sesgo.

Los experimentos deben, en la medida de los posible, colocar a los individuos o a los grupos sobre los que se va a intervenir de forma aleatoria. Se deben seleccionar a los sujetos a estudio de forma aleatoria para reducir el sesgo.

11. Hay que repetir.

Los resultados que son consistentes en estudios repetidos en poblaciones independientes son mucho más fiables. Cuanto más repitas un experimento más fiable será. Los resultados de este tipo de estudios se pueden combinar y pueden tener mayor valor estadístico que un estudio individual. En broma, se suele decir en los laboratorios que “si un experimento te ha salido bien … no lo repitas!”, la segunda vez seguro que cambia el resultado, pero esta afirmación no deja de ser una broma.

12. Los científicos son humanos (aunque no lo parezcan).

Los científicos tienen un gran interés en promocionar su trabajo, a menudo para obtener fondos de investigación y prestigio profesional. Esto puede llevar a mostrar sus resultados de forma sesgada, selectiva, subjetiva o exagerada. La revisión por pares de muchas revistas no es infalible, y los editores de las revistas también pueden influir en la decisión final por razones de interés periodístico. Lo más convincente es que un grupo de investigación independiente repita el experimento y obtenga el mismo resultado.

13. La significación estadística es «significante» (importante).

La significación estadística expresada como P es una forma de medir la probabilidad de que un resultado ocurra por casualidad. Una P = 0,01 quiere decir que hay 1 probabilidad entre 100 de que lo que parece un efecto del tratamiento haya ocurrido en realidad por azar. Por eso, cuanto menor sea la P, más fiable es el resultado, mejor. Normalmente se suele aceptar que una P inferior de 0,05 (1 en 20) es un resultado estadísticamente significativo.

14. Efecto nulo no es lo mismo que la falta de significación estadística.

Un resultado que sea estadísticamente no significativo (por ejemplo, con una P mayor de 0,05) no quiere decir que el resultado sea nulo y que no hubo ningún efecto. Significa que no se ha detectado ningún efecto, que es distinto. Quizá si el tamaño de la muestra fuera mayor, se podría haber observado algún efecto.

15. El tamaño (del efecto) si importa.

La importancia del tamaño del efecto si importa, es una cuestión biológica, física o social, y no estadística. El resultado puede ser estadísticamente significativo, pero el efecto puede ser muy pequeño y por eso poco significativo estadísticamente, pero muy importante desde el punto de vista biológico.

16. No se puede generalizar.

La relevancia que tenga un estudio depende de que las condiciones en las que se ha hecho sean lo más parecidas a la situación real. Por ejemplo, hoy en día somos capaces de curar casi todas las enfermedades humanas … en ratones. Los resultados positivos en los experimentos con animales no siempre se repiten en los seres humanos. No somos ratones.

17. Los sentimiento influyen en la percepción del riesgo.

El riesgo es la probabilidad de que ocurra un evento en un período de tiempo, multiplicado por las consecuencia en caso de que ocurra. La percepción del riesgo depende de muchos factores, de la probabilidad de que ocurra, del control que nosotros pensamos que tenemos de la situación, de la adversidad de los resultados, de si el riesgo es voluntario o no. Por ejemplo, en EE.UU. las personas subestiman el riesgo asociado a tener una arma de fuego en su casa y sobreestiman los riesgo de vivir cerca de una central nuclear, por ejemplo. Es una cuestión de sentimientos.

18. El riesgo cambia cuando confluyen varios factores.

Puede ser fácil calcular las consecuencias de un evento individual, pero si coinciden varios factores a la vez, la probabilidad del riesgo cambia totalmente.

19. Los datos pueden ser seleccionados intencionadamente.

Las evidencias puede manipularse para apoyar una determinada hipótesis o punto de vista. No es lo mismo interpretar los datos (previamente seleccionados) con una hipótesis de partida única, que llegar a un hallazgo a partir de un enorme conjunto de datos sin seleccionar.

20. Las comparaciones son odiosas.

Hay variables que depende de múltiples factores. Si los resultados se simplifican y se atribuyen a un solo factor, se puede cometer un error de interpretación. Por eso, las comparaciones de resultados que dependen de muchos factores pueden ser poco fiables.

Policy: Twenty tips for interpreting scientific claims. W. J. Sutherland, D. Spiegelhalter & M. Burgman. Nature. 2013. 503: 335–337. doi:10.1038/503335

Soy profesor de microbiología y virología en la Universidad de Navarra. Los que me conocen saben que soy un tipo muy serio y que todo lo que escribo está basado en evidencias científicas, todo … o casi todo, je je. Intento descubrir por qué algunas bacterias son tan malas y producen enfermedades, y trabajo para desarrollar nuevas vacunas y nuevos métodos moleculares para detectar las bacterias. Me apasiona el mundo de los microbios, bacterias y virus, y disfruto contando historias en los blogs microBIO y El rincón de Pasteur (de Investigación y Ciencia). He publicado Virus y pandemias para meter miedo y luego ¿Funcionan las vacunas? (Premio Prismas 2018) para solucionarlo. Microbiota: los microbios de tu organismo es un libro de autoayuda (je, je), para conocerte mejor y nunca sentirte solo o sola: la mitad de lo que tú eres son bacterias. Lo último ha sido Preparados para la próxima pandemia: reflexiones desde la ciencia. Otro libro que he escrito con mi hija es Princesas de cristal, otra apasionante historia que nada tiene que ver con los microbios. En Twitter soy @microbioblog. En la foto de perfil salgo con pelo, pero ya lo he perdido.