Kim Kardashian es eso tan curioso que se conoce como «una famosa». A pesar de que no se sabe que haya hecho nada relevante en ningún tema relevante (ciencia, política, arte, música, crimen), es una de las personas con más seguidores en twitter (26,6 millones) y su nombre está entre los más buscados en google. Al parecer su fama inicial proviene de un encuentro privado entre ella y un amigo, que fue grabado en video en 2003 y esa particular película amateur acabó en ese conventillo virtual que es internet en 2007. La demanda que presentó a la distribuidora Vivid Entertainment se zanjó con un acuerdo por 5 millones de dólares y pasó a ser lo que en el mundo anglosajón se denomina una «celebrity», el salto a la fama.

Es cierto que su entrada en Wikipedia la define como actriz, diseñadora de moda, personaje social, personalidad de los medios sociales y la televisión, modelo y mujer de negocios pero no es menos cierto que esos negocios se basan en unir su nombre y su perfil público a una marca determinada o un evento. Recibe «royalties» de lápices de labios, zapatos, ropa, alimentos dietéticos, videos de gimnasia, videojuegos y hasta pastelitos. A lo largo de los años ha tenido cameos en distintas series, ha participado en concursos estilo Mira quien baila, ha actuado en distintas películas, ha sido tertuliana —en 2010 se le consideró el personaje mejor pagado de televisión, con unos ingresos estimados en 6 millones de dólares anuales— y ha tenido su propia serie de televisión. En invierno de 2014 ella, o mejor su culo, fue protagonista de la portada de la revista Paper. Hubo muchas críticas tanto en los medios tradicionales como en internet a lo que era considerado un importante retroceso en la defensa de una imagen digna de la mujer y también es cierto que la página web de Paper pasó de las 25.000 visitas que tenía de media, a 15,9 millones en un solo día.

La fama y la popularidad entre los investigadores es un asunto resbaladizo. Neil Hall recuerda el caso de Mary Anning, una fosilista, como se llamaba en su tiempo a los paleontólogos, cuya recolección meticulosa y prolífica de fósiles fue clave en el avance de la Historia Natural en el siglo XIX, en particular en el conocimiento de la extinción de las especies. Otro ejemplo es el Ada Lovelace, la hija de Lord Byron que ha sido reconocida, también mucho después de su muerte, como la escritora del primer programa informático o Rosalind Franklin, cuya investigación fue decisiva para elucidar la estructura del ADN y tuvo muy poco reconocimiento en vida. A eso sumo yo el caso de Marthe Gautier, probable descubridora de que el síndrome de Down es una trisomía. No es casualidad que las cuatro sean mujeres.

La fundación de la Royal Society de Londres en 1660 creó un nuevo tipo de ciencia. Hubo el primer científico a sueldo (Robert Hooke, descubridor de la célula y comisario de experimentos), la primera reunión periódica de especialistas (congresos, simposia y encuentros, como los que ellos realizaban en el Gresham College), la comunicación internacional (como las cartas que Leeuwenhoek mandaba desde Holanda con sus descubrimientos) y la publicación de los resultados de la investigación no solo en libros sino también en revistas especializadas (Philosophical Transactions of the Royal Society, fundada en 1665 )

Este modelo ha llegado con bastante uniformidad hasta nuestros días. Voy a hacer una serie de afirmaciones que creo tienen un respaldo mayoritario entre los investigadores pero también, en mi opinión, un apoyo que es decreciente en el orden en que las presento:

1.- La investigación debe ser publicada. Algunos llegan a decir que la investigación no publicada, no existe. Una investigación no publicada no puede ser juzgada, ni puede ser confirmada o continuada y corre el riesgo de ser repetida, con el consiguiente dispendio de tiempo, esfuerzo y dinero.

2.- La publicación de una investigación debe buscar la máxima difusión, por lo que debe hacerse en inglés. Aquí existen críticas tanto desde un punto de vista nacionalista —nuestro idioma debe ser una lengua científica— o justificaciones por una supuesta especificidad de la investigación —yo estudio los orígenes etnológicos de la sardana, por lo que mis lectores va a ser mayoritariamente catalanes y debo dirigirme a ellos en su lengua aunque mi investigación sea tan interesante e importante como lo mejor publicado en inglés.

3.- La mayor difusión la tienen las revistas que llamamos «de impacto» por lo que debemos intentar publicar en ellas. Algunos investigadores que no publican en estas revistas siempre utilizan el argumento de artículos malos publicados en buenas revistas o artículos excelentes publicados en revistas desconocidas, pero parece claro que se trata de excepciones a una regla general que podemos definir como que la mejor investigación se publica normalmente en las revistas mejor valoradas.

4.- El impacto de una publicación determinada se puede medir con indicadores bibliométricos como el número de citas por otros autores. Asumido esto, es también cierto que un tipo determinado de artículo como los metodológicos o las revisiones tiene comparativamente muchas citas y un articulo especialmente malo, como un plagio o un supuesto avance que luego resulta ser falso, recibirá un numero alto de citas, aunque sea para vilipendiarlo. Como regla general, en los artículos «normales» la investigación más novedosa será normalmente más citada, siempre por supuesto comparando dentro de la misma disciplina.

5.- La calidad relativa de un investigador es difícil de medir pero se puede conseguir una aproximación razonable con sus publicaciones (cantidad, calidad de las revistas y citas específicas de sus artículos). Estos criterios son los usados en muchas de las evaluaciones tanto para la financiación de un proyecto como para una promoción en la universidad o en el CSIC. La prueba de que no es fácil es que no se usa un algoritmo que permitiera una valoración automática ni tampoco es un trabajo mecánico que pueda ser hecho por personal administrativo sino que se requiere siempre la participación de especialistas del mismo área de conocimiento y nivel similar o superior al solicitante que puedan hacer una evaluación razonada.

6.- Hay que complementar la publicación especializada con una difusión más amplia de las investigaciones. Un artículo en una revista especializada tiene por definición una audiencia reducida, los especialistas que trabajan en el mismo tema o un tema relacionado. Las agencias de financiación de la investigación requieren frecuentemente un plan de difusión de la investigación. Se piensa que es parte de un retorno: como la investigación es financiada por la sociedad con sus impuestos hay que darle cuentas de lo realizado y conseguido. Bastantes investigadores reniegan de esta exigencia y la consideran una pérdida de tiempo, un requisito molesto, una degradación. Personalmente creo que es algo necesario y adecuado, imprescindible para aumentar la cultura científica de la sociedad y aumentar el respaldo a la investigación.

7.- Los investigadores deben usar las redes sociales. No sé siquiera si en una encuesta el respaldo a esta afirmación sería mayoritario e imagino que hay también un componente generacional. Quizá es necesario distinguir entre medios de comunicación tradicional (redes sociales clásicas) y los medios digitales (redes sociales modernas). Muchos investigadores usamos redes sociales pero es posible que la mayoría lo hagan más para aspectos personales que profesionales. Por otro lado, hay muchos divulgadores que utilizan con fruición las redes sociales para contar investigación aunque no sean ellos los que la han hecho. El número de científicos que usan twitter, Facebook, pinterest u otros para difundir su investigación creo que va creciendo pero es aún minoritario.

En julio de 2014 Neil Hall ha publicado un estudio en la revista Genome Biology donde establece un nuevo índice que ha denominado índice Kardashian.

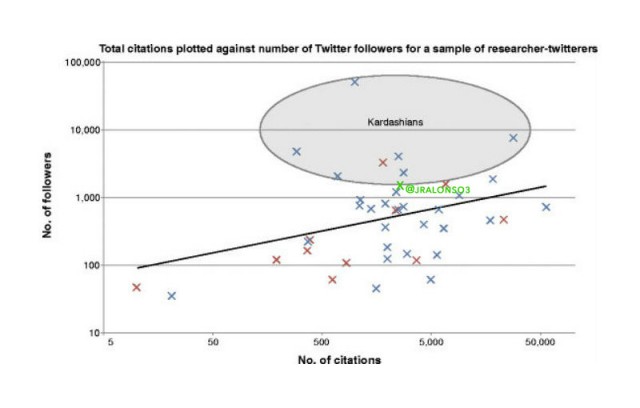

Medio en broma, medio en serio, Hall compara el impacto especializado de un investigador (medido mediante el número de citas de sus publicaciones) con el impacto social del mismo investigador (medido mediante el número de seguidores en twitter). Ha seleccionado una muestra de 40 investigadores que llevan un tiempo en twitter, ha eliminado aquellas referencias iniciales de la Genómica que se han convertido en «clásicos» y por eso son citados reiteradamente y ha establecido una correlación. Por encima de un valor de 5 estarían los científicos «kardashians», aquellos que son famosos, tienen mucha presencia social, salen en programas de televisión o medios de comunicación pero luego no tienen apenas investigación relevante propia. Aquí lógicamente no encajan los divulgadores, periodistas y otros profesionales que hacen una magnífica labor pero no hacen investigación. Valores de índice Kardashian (K-index) muy bajos significan —según Hall— científicos infravalorados, cuya investigación es reconocida por sus colegas pero no por el público en general o que simplemente no trabajan las redes sociales.

El índice Kardashian se puede definir como la razón entre el número de seguidores en twitter (S) y el número de seguidores esperable (Se) según el número de citas de sus trabajos (C)

Se=43,3.C0,32

IK= S/Se

La revista Science exploró el índice Kardashian y resulta

1) Solo un quinto de los científicos con más impacto (con más citas) tenían una cuenta de twitter identificable.

2) Los tres científicos con más seguidores en twitter tienen índices K muy altos, lo que les convertiría según Hall en científicos kardashians pero todos reconocemos un alto valor a su trabajo, para la ciencia y para la sociedad.

Neil deGrasse Tyson, astrofísico tiene más de 2,4 millones de seguidores en su cuenta de twitter (@neiltyson) pero solo 151 citas, así que su K-index es de 11.129.

Brian Cox, físico, tiene 1,4 millones de seguidores en twitter (@ProfBrianCox) y 33.301 citas, por lo que su K-index es de 1.188.

Richard Dawkins, biólogo, tiene 1.02 millones de seguidores en twitter (@RichardDawkins), 49.631 citas, por lo que su K-index es de 740.

En mi caso, en el momento en que escribo esto, mis seguidores en twitter (@jralonso3) son 1.513 y las citas a mis artículos científicos 2.540, por lo que mi K-index es 2,8.

Me parece una propuesta provocadora y divertida pero creo que tiene muchos flancos débiles:

- Igual que los mejores científicos a veces son malos profesores, pueden ser un desastre en las redes sociales y viceversa.

- Las redes sociales priman ciertos perfiles (provocativos, exhibicionistas, conflictivos, divertidos, etc.) No son perfiles particularmente relacionados con la actividad científica.

- El perfil público y el número de seguidores se multiplica por la presencia en medios tradicionales, en particular la televisión, que a su vez busca a la gente popular. Kim Kardashian es un buen ejemplo. Es un factor enorme de distorsión.

- La mayoría de los científicos que estamos en twitter no tuiteamos exclusivamente ni siquiera mayoritariamente sobre nuestra propia investigación. Son las mismas personas pero dudo que sean actividades paralelas. ¿A mayor investigación, mayor presencia en twitter, más seguidores? No lo creo.

- Sería interesante ver los seguidores de los investigadores que además somos profesores ¿Son nuestros alumnos? ¿Sumamos una nueva cohorte cada año?

El análisis por Science de los 50 científicos (anglosajones, aunque ellos no lo indiquen) con más seguidores en twitter muestra otro aspecto deprimente: solo cuatro son mujeres. El análisis por Mètode de los científicos tuiteros en España tuvo el mismo problema, las mejores no aparecían inicialmente aunque fueron detalladas en los comentarios. El porqué es complejo. La astrónoma Pamela Gay (@starstryder), cuyos 17.000 seguidores la ponen en el puesto 33º dice que es algo que no le sorprende porque a la sociedad todavía le cuesta reconocer a mujeres como líderes en ciencia. Las científicas también tienen más probabilidades de sufrir comentarios sexistas de los típicos imbéciles que se esconden en el anonimato. Según ella decía «En algún momento te hartas con todos los comentarios del tipo “porque eres fea” o “porque estás buena”».

Algunos académicos son muy críticos sobre el tiempo dedicado a las redes sociales mientras que otros pensamos que es una herramienta útil y un tiempo bien invertido. En este post puedes leer cómo usar twitter como una herramienta para la docencia y la investigación.

En junio de 2014, Kim Kardashian sacó un juego para móviles (iPhone y Android) titulado Kim Kardashian: Hollywood. El objetivo del juego es convertirte en una estrella de Hollywood o una starlet. Como muchos otros juegos para móviles, tiene una versión gratuita y luego pequeños cargos para nuevas prestaciones. El juego fue un éxito ganando 1,6 millones de dólares en sus primeros cinco días. En julio, la empresa desarrolladora, Glu Mobile, anunció que era el 5º juego según beneficios en la Apple Store. ¡Esto sí que es otro tipo de ránking y factor de impacto!

Para leer más:

Hall N (2014) The Kardashian index: a measure of discrepant social media profile for scientists. Genome Biol 15(7): 424. http://genomebiology.com/content/pdf/s13059-014-0424-0.pdf

You J (2014) The top 50 science stars of Twitter. Science http://news.sciencemag.org/scientific-community/2014/09/top-50-science-stars-twitter

http://en.wikipedia.org/wiki/Kim_Kardashian

José Ramón Alonso (Valladolid, 1962). Doctor en Neurobiología por la Universidad de Salamanca, donde es ahora Catedrático de Biología celular. Ha sido Rector de esta Universidad e investigador postdoctoral y profesor visitante en Alemania y Estados Unidos. Escribe en su blog sobre divulgación científica y el mundo universitario así como en prensa española e internacional.