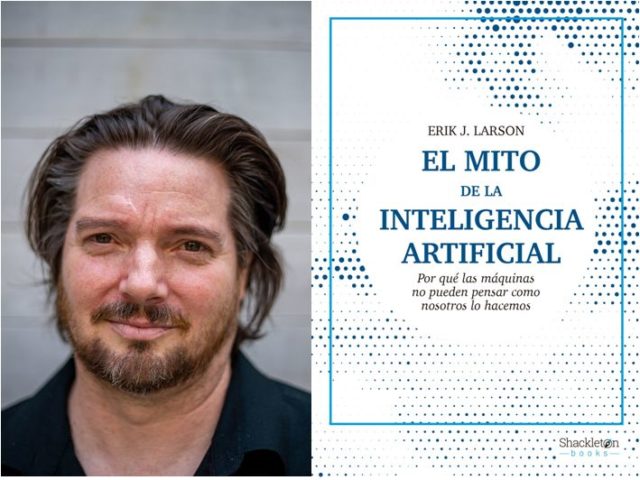

El transhumanismo tiene muy claro que la inteligencia artificial y la singularidad llegarán. Solo es una cuestión de tiempo. Hay otras opiniones menos triunfalistas, como la de Erik Larson, que ha publicado recientemente El mito de la inteligencia artificial (Shackleton Books, 2022). Este es uno de los mejores libros que hay sobre inteligencia artificial, si no el mejor. El lector se familiarizará con términos nuevos que van más allá de los ya trillados test de Turing o ELIZA. Larson explica la abducción de Peirce (nada que ver con la ufología, claro) y los esquemas de Winograd para elevar la investigación en inteligencia artificial a su verdadera complejidad.

ANDRÉS LOMEÑA: Me enamoré de las fantasías de Ray Kurzweill cuando era universitario. Ahora soy muy escéptico con sus ideas, pero Kurzweill sigue empeñado en que el test de Turing se va a superar en 2029. Sugiero que esperemos siete años para demostrar que estaba empíricamente equivocado y ya está. En cualquier caso, el deep learning y el machine learning no son suficientes para llegar a una “inteligencia general”.

ERIK LARSON: Exacto. Sabemos que la inducción es inadecuada para generar una inteligencia general. Por lo tanto, sabemos que todos los enfoques de deep learning que crean grandes modelos para el procesamiento de lenguajes naturales (NLP) ayudan, pero no son suficientes para una inteligencia artificial general (AGI). Además de la inducción, necesitamos otros tipos de inferencia. He defendido que necesitamos el razonamiento abductivo.

A.L.: Pedro Domingos busca un algoritmo maestro o definitivo. ¿No estará perdiendo el tiempo?

E.L.: No lo creo. Lo que él hace me parece interesante para la inteligencia artificial. Domingos ha investigado cómo obtener reglas a partir de los datos, lo que resulta prometedor, aunque no sea una técnica perfecta. Un enfoque híbrido que implique las cinco tribus que él ha categorizado [cinco paradigmas del aprendizaje automático] seguramente supondrá un progreso en este campo.

A.L.: ¿Pinta algo la computación cuántica en todo esto?

E.L.: Mi investigación ha sugerido que hay problemas de base bastante importantes, como conseguir que la superposición de una masa apreciable sea estable y ese tipo de cosas. No sabría decir cuál va a ser el futuro de la IA respecto a la computación cuántica; lo que sí creo es que todavía nos las veremos con grandes obstáculos teóricos y prácticos.

A.L.: Internet y la World Wide Web crearon una enorme expectación en el mundo. Después de algunos años, tal y como describe en su libro, esa esperanza parece haberse desvanecido. Su preocupación con la IA es parecida a la de la web: los mitos de la inteligencia artificial están destruyendo la posibilidad de llegar a innovaciones reales.

E.L.: Creo que los intereses de las Big Tech (Google, Facebook y otras) unidos a la obsesión por grandes modelos de sistemas de aprendizaje automático es mostrar poca innovación. Añadir más datos no deja de ser más de lo mismo. Ideas como la web semántica son una posibilidad interesante, pero no hay muchas personas dedicadas a eso ahora mismo. La comunidad de la web semántica ha sobrevivido, hasta cierto punto, gracias a los grafos de conocimiento. De un modo u otro, las nuevas ideas que nos llegan son menos transgresoras que las de antes; tengo la sensación de que la web se ha agotado y de que las mejores ideas se descubrieron a principios de los dos mil. Ahora estamos esperando una nueva innovación que aporte experiencias completamente nuevas.

A.L.: No estoy al tanto del proyecto de Henry Markram. ¿Qué representa el Human Brain Project?

E.L.: El Human Brain Project empezó como un intento muy ambicioso de mapear el cerebro humano usando la llamada “neurociencia predictiva”. Tal y como sugiere esta expresión, es una forma de aplicar los sistemas más avanzados de deep learning a predecir cómo se conectan los diferentes grupos de neuronas (el conectoma). Dijeron que se había logrado un ochenta por ciento de éxito, lo que suena muy bien, solo que eso también significa que dos de cada diez conexiones son falsos positivos. Para mapear el cerebro, necesitaremos métodos más precisos. Creo que aún no existen esos métodos y que entretanto proyectos como el Human Brain Project están consumiendo recursos de supercomputadoras que, con las ideas consabidas sobre el cerebro, fingen que están haciendo algo innovador. Y no es así. Hacen falta nuevas ideas y no hay capacidad computacional que sustituya esa necesidad.

A.L.: En definitiva, que necesitamos algo nuevo y ese método no parece que esté cerca.

E.L.: Me gustaría ver más investigaciones en inducción de reglas. Se deberían combinar los métodos de aprendizaje automático con más métodos convencionales de razonamiento y de representación del conocimiento. En ese contexto de investigación, sí que podría aparecer algo nuevo y muy diferente.

Esta entrevista nos la envía Andrés Lomeña Cantos (@andresitores). Estudió periodismo y se especializó en teoría de la literatura y literatura comparada. Trabaja como profesor de filosofía en un instituto de educación secundaria e investiga sobre los mundos imaginarios de las novelas.

En este enlace puedes encontrar más entrevistas de Andrés Lomeña publicadas en Naukas.

Si tienes un artículo interesante y quieres que lo publiquemos en Naukas como colaborador invitado, puedes ponerte en contacto con nosotros.